此前记录和分享的文章中,我提到过我已经不再续费Claude Code了,因为他们家的基础Pro套餐,我还没怎么开始用就开始出现限额了,必须升级到Max才行,在使用了一个月后,鉴于它实在是有点贵,最终我还是切换到了Cursor和Antigravity上。不过Claude Code毕竟代表着先进的生产力,先不论其背后模型在Coding领域的优秀表现,即便Claude Code这个前端产品依然还是很能打,尤其Claude Code支持了Agent Skills后,更是可以让LLM开盲盒的流程有了更好的确定性。

为了能继续使用Claude Code这个产品,实际上我还付费买过智谱的GLM Coding Plan Pro继续使用了一段时间,但是鉴于模型能力确实还存在一定的差距,所以在使用了一段时间后,还是切到了Cursor和Antigravity。OpenAI的ChatGPT毕竟还是C端产品的心智首选,同时自带Codex的Plus用量,所以一直也都有持续在付费,这个月把大量的工作切换到Antigravity后发现它也很能打,而且提供了目前Coding能力Top的模型:Gemini 3 Pro和Claude Opus 4.5,高强度使用下也未出现限量或者降速的体验问题,所以趁势先把Cursor Pro停了(能省一点是一点吧)。

所以现在我手上付费订阅的AI产品除了JetBrains AI Pro外,就只剩下ChatGPT Plus和Google AI Pro了,而JetBrains AI Pro相对比较封闭,是一个非常垂直的Coding Agent产品且跟JetBrains全家桶绑定较深,这里先按下不表。而OpenAI和Google家的这两个订阅实则不只是订阅了一个AI Coding Agent的使用权限,那都是一个家族谱系的产品。

OpenAI ChatGPT Plus和Google AI Pro这两个订阅开通后,我们不只是可以直接使用ChatGPT和Gemini中内置的付费功能和权益,实际上还拥有了Codex和Antigravity的付费功能,而这些权益中最核心的就是AI服务Token的用量,且得益于AI行业发展超级快,还没轮到各家分裂自立门户或者通过标准组织建立标准,已经有两家公司率先成为了事实上的行业标准,那就是OpenAI家的Chat Completions API和Anthropic家的Claude Code Messages API,已经成为了行业内其他各家推出产品时直接参考和兼容的标准。这也是为什么我们可以购买国内的智谱、Kimi、MiniMax家的Coding Plan产品便可以直接对接到Claude Code上进行使用,只是Claude Code最终调用的模型能力由我们配置的这些国内厂商提供。

在这么个事实上开放的背景下,实际上我们要使用Claude Code这样优秀的产品,实际上并不一定要局限在使用Anthropic家的订阅或者官方直通API,Claude Code从发布之初就默认支持调用API的方式来访问,也是考虑到B端用户的真实场景,存在着大量的企业用户可能需要从微软、AWS等等其他模型服务提供商处采买AI API服务的情况。这也给我们国内广大的程序员们提供了一个低价且稳定又快速使用Claude Code的优秀产品能力,提升自己编码和工作幸福度的机会。

这不,昨天晚上写完告别2025的公众号文章后,想着前不久给自己2026年写字加了个小附加条件,除了一年写够52篇文章外,还需要把在微信公众号发布的文章,同步记录和发布到我自己的博客站点上去。

这不赶上了嘛,前不久我自己琢磨了一个周末,给自己做了一个每周处理工作上业务周报的Skill,每周一写周报的时候不再那么着急忙慌了,属实是真香系列,但是在我停用了Claude Pro的订阅后,GLM 4.6模型又总是不太给力,时不时给出的结果不尽如人意,在我切换到Antigravity后,我也试图让Antigravity去执行这个Skill,但是最终结果也不太如意,每次执行都要不断跟它来回地沟通和确认,并且Antigravity总是在试图修改Skill目录下的脚本,看上去很不够稳定。上周智谱上市前,他们家发布了GLM 4.7模型,我简单体验了一下,发现还是不错的。所以这周一的周报大纲,就是Claude Code通过周报Skill调用智谱的GLM 4.7模型进行数据分析后输出,然后我再二次加工的。

想起以后每次写完微信公众号文章后,我还得自己手动把文章内容再发布到自己的博客站点上,我就头大。首先,复制粘贴就很无聊,其次,如果文章中有图片,还得再次手动上传到博客站点,最后,博客站点的内容发布在手机上是很不友好的,而我绝大部分的写作都是在手机上完成的。那我以后是不是每次发完微信公众号后,还得打开电脑再手动发布一下博客文章,想想都难受。那么这种重复且繁琐的事情显然可以借助Claude Code搭配Agent Skills来完成,说干就干。

把需求给Claude Code描述好,需求如下:

实现一个可以一键把微信公众号同步发布到WordPress站点的Skill,需要支持设置博客文章的固定链接、文章分类、文章标签。

没一会儿,补充了一些相关的信息以及和WordPress发布文章鉴权相关的参数,Claude Code便帮我把这个Skill写好了,内容结构如下:

找了几篇此前已经发布的微信公众号文章的链接,丢给了Claude Code,让它帮忙同步,验收结果。

来回验收多次,补充了几个特性:

1. 自动读取微信公众号文章标题,调用大模型翻译成简短的因为slug作为固定链接后缀部分,避免出现链接地址中是中文标题的URL Encode字符,表意清楚对于搜索引擎也更友好(虽然小站完全没流量);

2. 自动下载微信公众号文章中的图片原图,上传到博客站点的媒体库,并替换文中的图片链接(微信公众号图片是防外链的);

3. 自动读取微信公众号文章发布的时间,在博客文章内容的底部新增本文的首发链接(微信公众号文章链接)和发布时间信息(咱们这也是在向其他作者们学习,每每写文都要写下类似于 “2026.01.01 于北京顺义” 这样的脚注);

4. 自动读取微信公众号文章的封面(实际上打开文章是看不到的哦),把这个封面图片作为WordPress博客文章的特色图片。

最终在凌晨2点45前后,终于完工了,在打磨这个Skill的过程中,我发现GLM 4.7还是不太能很好的理解我的意图并且比较好的还原我的指令,虽然这个Skill当前已经完全能满足我的需求了,但是为了打磨它,我花了足足3个小时才把它完成。我觉得模型的能力,与我最近几天使用Cursor和Antigravity编码过程中解决复杂问题的体验相差还是不小。

今天一早起来,便想起此前在X上看到了几位推友分享的关于Coding Agent订阅API Token余量实时查询和展示的工具中,有两款产品除了能实现多厂商多账号余量的实时显示,还能在本机建立一个代理服务,对外提供服务,很像是此前我在学习Claude Code的时候了解到的一个名为LiteLLM(https://www.litellm.ai/)的AI服务网关产品提供的能力。而且从推友分享的图片中能看到,推友们把自己申请的免费账号和付费账号的Claude家的Opus 和 Sonnet API Token直接给到Claude Code去用了,这简直就是一鱼两吃嘛。想起我自己手上的Google AI Pro订阅账号里头,Claude家的API Token基本上就没有用过,我还为了能继续使用Claude Code又额外订阅了GLM Coding Plan,如果能直接把Google AI Pro账户中的Claude家的模型直接分享给到Claude Code用的话,那这20美金可就真的花得千值万值了。想到这里便记下了,今天得试试看到底能不能跑通。

上午带着娃儿们去了一趟公园,大娃上周去公园时看公园里湖上搞起了冰雪嘉年华活动,可以在冰面上玩各种雪具,很是心动,上周他的左脚因为此前在公园里玩滑雪受伤了还没有完全好,这周已经好多了,就很是心痒,进了公园门就往场地跑。我们到的那会儿,人还不多,买票后,兄弟俩就自己下冰面上去玩耍去了,我就在公园里围着冰面散步蹓跶。等哥俩儿玩累了,上来找我的时候已经是快11点半了,回家后吃过午饭,带着哥俩睡了会儿午觉(哥俩儿闭着眼睛在床上硬躺了一个小时,愣是没睡着)。午觉后,哥俩写作业的去写作业了,看书的就看书,我换上衣服出去跑了一圈,2026年新年第一跑,简单跑了个5公里。

跑步回来洗个澡,娃儿们还在学习和看书中,我便开始逐一了解,此前X上推友们分享的项目。

Quotio

Quotio:The ultimate command center for your AI coding assistants(https://github.com/nguyenphutrong/quotio)

Quotio支持的产商真不少:

AI Providers

Provider Auth Method Google Gemini OAuth Anthropic Claude OAuth OpenAI Codex OAuth Qwen Code OAuth Vertex AI Service Account JSON iFlow OAuth Antigravity OAuth Kiro OAuth GitHub Copilot OAuth

还支持实时监听IDE的用量和余量:

IDE Quota Tracking (Monitor Only)

IDE Description Cursor Auto-detected when installed and logged in Trae Auto-detected when installed and logged in

除了能实时监听显示以上厂商的账号和工具的用量和余量之外,更美丽的是,它能直接提供本地可供以下AI Coding Agent访问的中心化服务接口

Quotio can automatically configure these tools to use your centralized proxy:

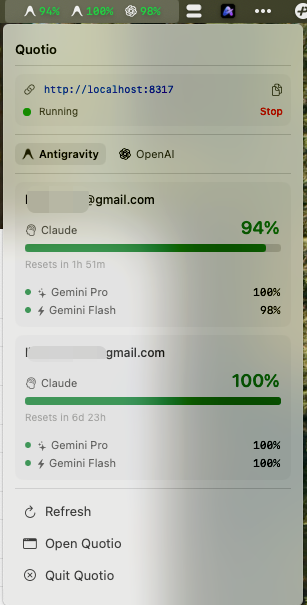

下面给大家看一下 Quotio 在系统状态栏中的显示效果

以及打开Quotio的主面板后的截图,一图胜千言,大家一眼就能看出来这个工具的功能了。

不过我想重点分享的是👇下面这个页面的内容:

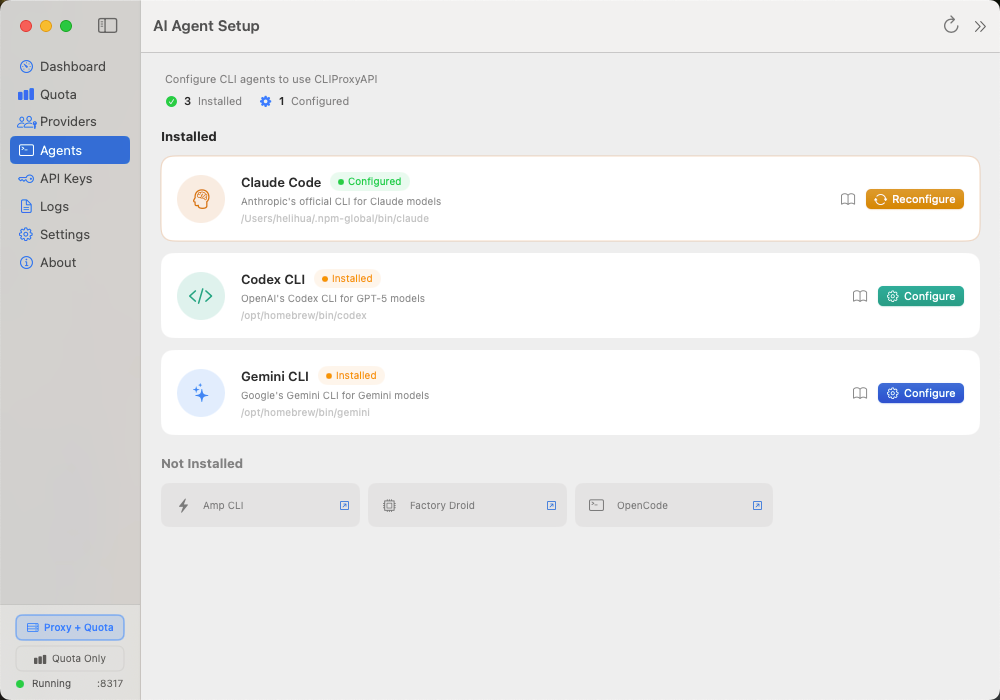

从这个页面中我们可以看到,Quotio支持Proxy+Quota模式,也就是在帮我们实时查询所有账号的用量余量的同时,还可以在本地建立一个代理服务,提供给它目前支持单独Agent使用,其中就有Claude Code、Codex CLI、Gemini CLI、AMP CLI、OpenCode、Factory Droid,还支持一键设置生效,对于很多对命令行以及系统变量设置不太熟的同学们来说,简直就是福音,配置好,一键启用。

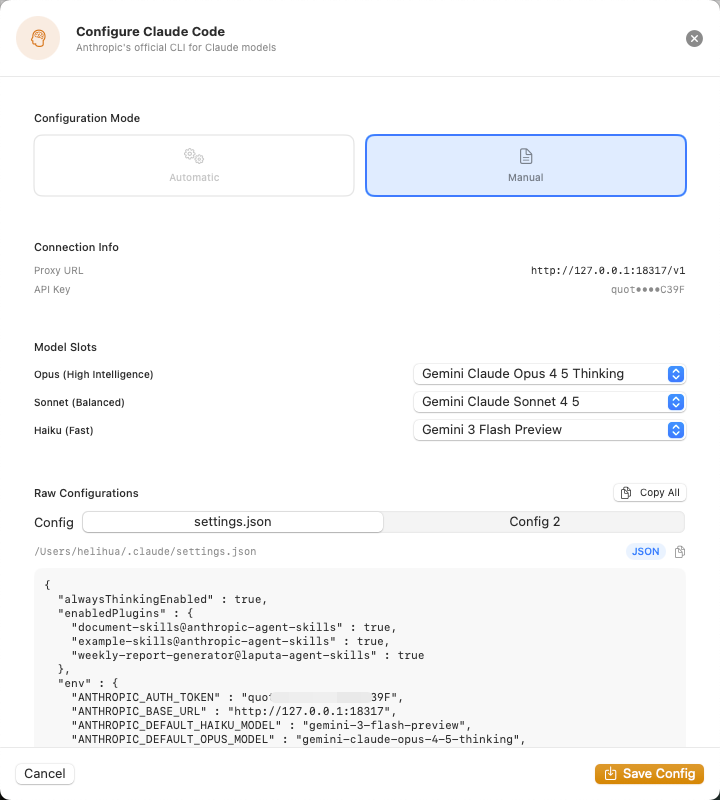

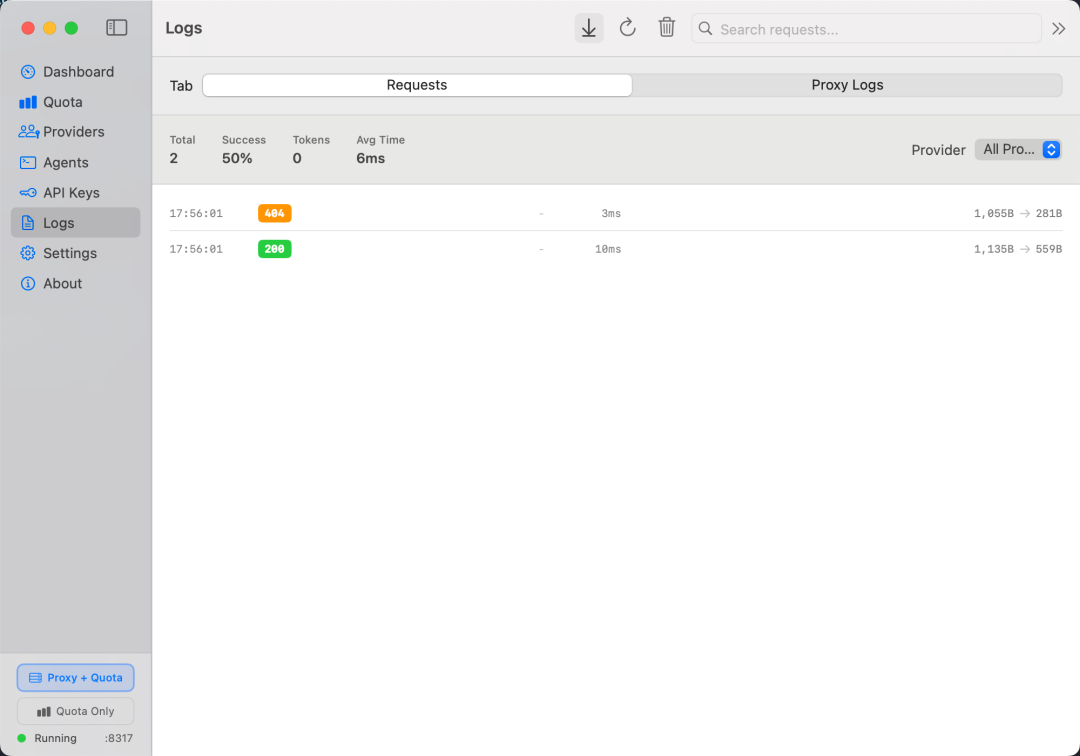

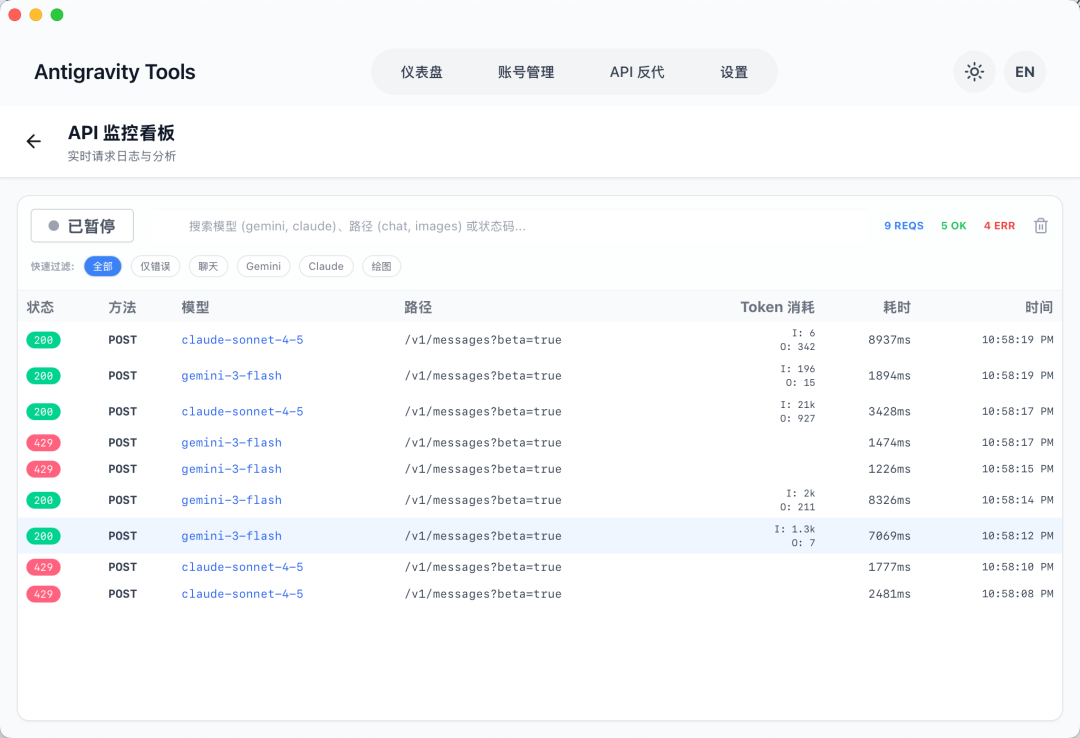

👆上面这个截图就是我使用Claude Code通过Quotio在本地创建的API反向代理服务,最终访问Google AI Pro订阅账号中提供的Claude Sonnet API的请求日志。

因为我自己有切换不同服务厂商的命令行方法,我只需要增加一个Quotio在本地创建的本地代理服务作为Claude的BaseURL,把模型名称跟Quotio中展示的模型名称对齐上就好了,参考GLM Coding Plan的Claude Code配置文档(https://docs.bigmodel.cn/cn/coding-plan/tool/Claude)修改对应参数即可。如果有多个账号,不同厂商的模型可供调用的话,Quotio还支持不同的负载均衡模式的设置,默认是Round Robin(轮询),可以修改为First Fill(依次分流,直到前序账号用量已满,切换到下一个)。最后给大家看一个跑起来后的请求日志单独截图,从此Claude Code不再依赖国产丐版模型了,Google家批发转赠送打包在Google AI Pro里头单独流量可不老少,且用呢,感觉比Anthropic家的Pro套餐也差不到哪儿去,这个我再验证验证☺️。

Antigravity Tools

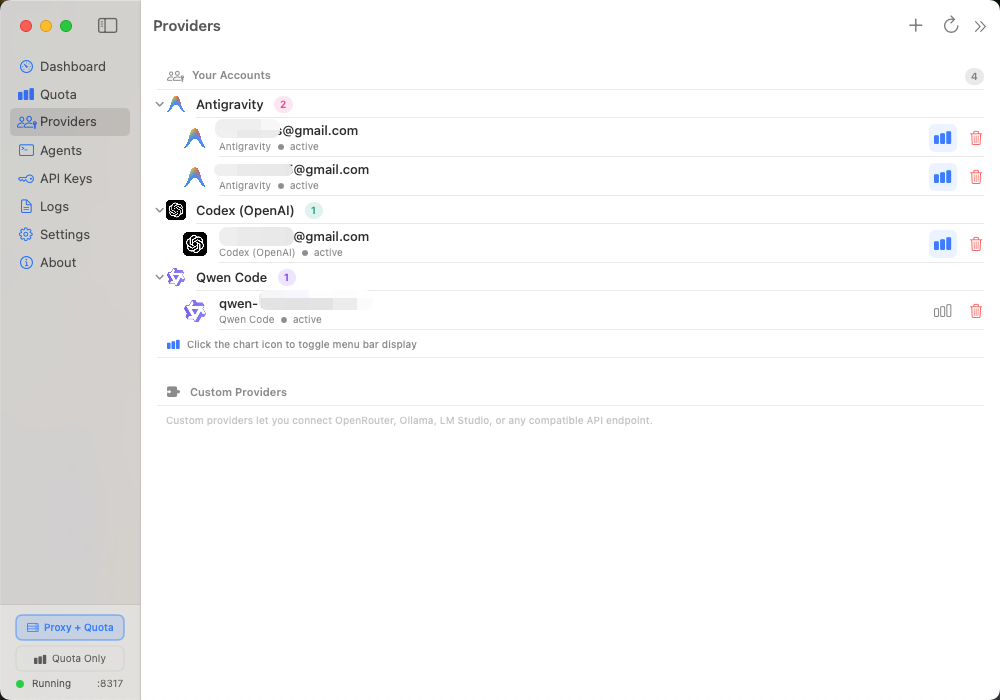

Antigravity Tools – Professional AI Account Management & Proxy System (https://github.com/lbjlaq/Antigravity-Manager)

这个名字朴素(甚至有些混乱,产品名称Antigravity Tools,项目名为Antigravity Manager)的小工具,典型的人狠话不多类型,其目前支持的工具和厂商不多,但是重在正经实用,最近网上折腾和买卖免费的美区Google账号,薅Antigravity免费用量的人一把一把的,我看这个项目的GitHub页面上提供的截图中,竟然显示着惊人的55个账号😱

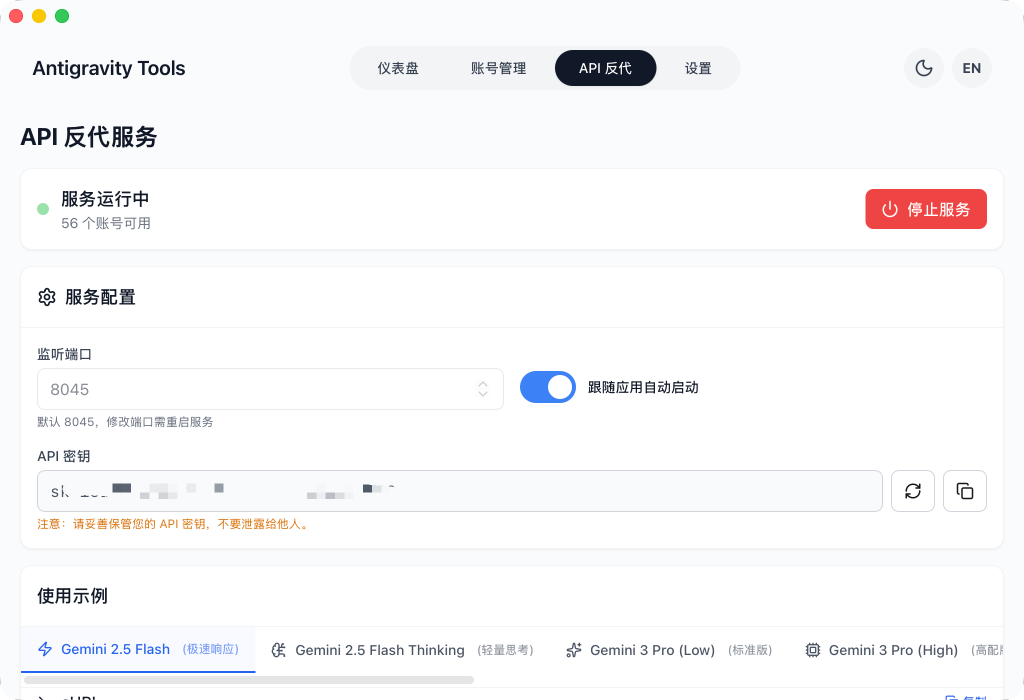

如果想要在Claude Code中使用Antigravity Tools提供的本地代理服务,那么需要从该软件的「API反代」页面中找到其在本地创建的反向代理服务监听的端口,以及它生成的API Key,把这些参数作为Claude Code的配置即可。这里同样可以参考GLM Coding Plan的Claude Code配置文档(https://docs.bigmodel.cn/cn/coding-plan/tool/Claude)修改对应参数。

最终的 ~/.claude/settings.json 文件配置看起来会是这样的:

{

"env":

{

"ANTHROPIC_AUTH_TOKEN": "sk-84b8bb2ecd0xxxxxxxfe13dae2c6f3",

"ANTHROPIC_BASE_URL": "http://127.0.0.1:8045",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "gemini-3-flash",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "claude-opus-4-5-thinking",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "claude-sonnet-4-5",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": "1"

}

}配置生效后,就可以使用Claude Code通过Antigravity Tools提供的本地代理服务,访问Google AI Pro提供的Claude系列模型,以及Gemini 3 Flash模型了。通过Antigravity Tools的「API反代」页面中的「打开监控」入口,进入「API监控看板」,点击「开始录制」后,在Claude Code中发起任意对话,就能看到请求都到Antigravity Tools的代理服务中来了。

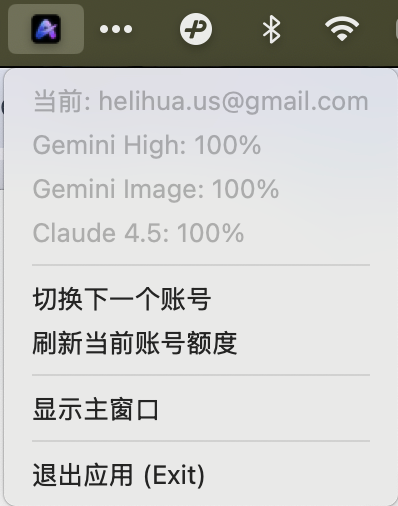

如此一来,Antigravity Tools这款专为Antigravity适配优化的本地多账号API用量管理和代理工具,就很好地帮我们解决了把Antigravity账号中的Claude API分享给Claude Code用的需求了。下面👇补充了一个Antigravity Tools在macOS系统状态栏中的功能界面的截图,供大家参考。

以上是两款功能基本相似,都能解决我们如何在不订阅Claude Pro/Max套餐的情况下免费继续高质量使用Claude Code的开源工具。其中Quotio应该是一名越南开发者的作品,而Antigravity Tools应该是我们中国开发者的作品。从Antigravity Tools的GitHub页面也能看到项目的赞助方是PackyCode(一家可靠高效的 API 中转服务商,这是页面上的原文)。

关于这种本地代理工具我想多说几嘴,虽然我的目的是把Google AI Pro账户中的Claude的API分享给到Claude Code使用,但是实际上这两个工具完全可以把它们支持的产商的API,最终通过这个反向代理的服务(类似于LiteLLM)提供给任意需要AI API的需求方,完全不需要局限在写代码的Agent的应用上,完全可以用来写小说、编剧本,如果模型支持文生图,那就可以用来做文生图,甚至文生视频,都是一样的。正是这些工具的蓬勃发展,包括上文提到的LiteLLM(https://www.litellm.ai/),让国内众多的API中转商们生意做得风生水起,解决了很多国内开发者和创作者的无法正常付款开通账号,很难保持网络稳定访问这些海外服务厂商提供的服务的问题。这种业务的工程创新,在某个阶段上来说,很有必要,也很有市场。

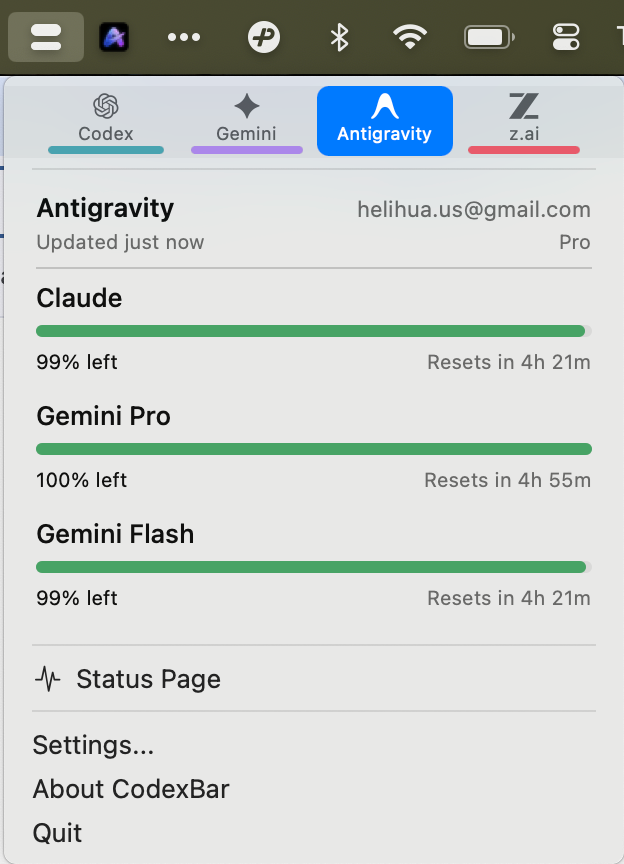

CodexBar

CodexBar 🎚️ – May your tokens never run out.(https://github.com/steipete/CodexBar)z

CodexBar就是一个纯粹用于实时查询各个AI账户用量和余量的状态栏工具,看一眼产品的截图就能明白了。如果你不需要一个本地的AI API反向代理工具的话,这个工具也是一个不错的选择。

以上就是我今天折腾半天,最终免费用上顶配的Claude Code套餐的学习和实践记录和分享,希望能给到大家一些启发。

🎉元旦快乐🎉

原文链接: 微信公众号